El concepto de aprendizaje less than one

El aprendizaje automático suele requerir numerosos ejemplos. Para conseguir que un modelo de IA reconozca un caballo, necesitas mostrarle miles de imágenes de caballos. Esto es lo que hace que la tecnología sea computacionalmente costosa y muy diferente del aprendizaje humano. Un niño a menudo necesita ver sólo unos pocos ejemplos de un objeto, o incluso sólo uno, antes de ser capaz de reconocerlo de por vida.

De hecho, los niños a veces no necesitan ningún ejemplo para identificar algo. Si se les muestran fotos de un caballo y un rinoceronte, y se les dice que un unicornio es algo intermedio, pueden reconocer a la criatura mítica en un libro ilustrado la primera vez que la ven.

MS TECH / PIXABAY

Un nuevo trabajo de la Universidad de Waterloo en Ontario sugiere que los modelos de IA también deberían ser capaces de hacer esto, un proceso que los investigadores llaman "less than one", o aprendizaje LO-shot (menos de uno). En otras palabras, un modelo de IA debería ser capaz de reconocer con precisión más objetos que el número de ejemplos en los que fue entrenado. Eso podría ser un gran problema para un campo que se ha vuelto cada vez más caro e inaccesible a medida que los conjuntos de datos utilizados son cada vez más grandes.

Cómo funciona el aprendizaje "less than one-shot"

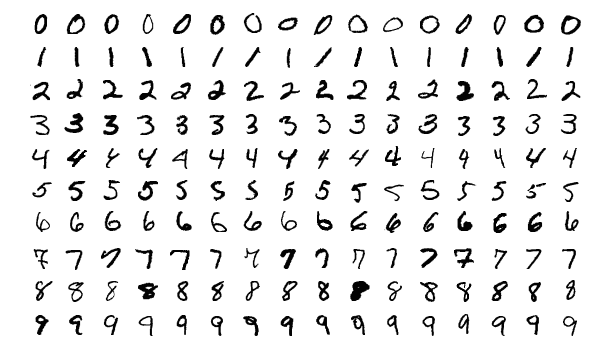

Los investigadores demostraron por primera vez esta idea mientras experimentaban con el popular conjunto de datos de visión por computadora conocido como MNIST. El MNIST, que contiene 60.000 imágenes de entrenamiento de los dígitos escritos a mano del 0 al 9, se utiliza a menudo para probar nuevas ideas en el campo.

En un trabajo anterior, los investigadores del MIT habían introducido una técnica para "destilar" conjuntos de datos gigantescos en otros diminutos, y como prueba de concepto, habían comprimido el MNIST a sólo 10 imágenes. Las imágenes no fueron seleccionadas del conjunto de datos originales, sino que fueron cuidadosamente diseñadas y optimizadas para contener una cantidad de información equivalente a la del conjunto completo. Como resultado, cuando se entrenó exclusivamente en las 10 imágenes, un modelo de IA podía lograr casi la misma precisión que uno entrenado en todas las imágenes del MNIST.

Las 10 imágenes "destiladas" del MNIST que pueden entrenar a un modelo de IA para lograr una precisión de reconocimiento del 94% en los dígitos escritos a mano.

TONGZHOU WANG ET AL.

Los investigadores de Waterloo querían llevar el proceso de destilación más allá. Si es posible reducir 60.000 imágenes a 10, ¿por qué no reducirlas a cinco? El truco, se dieron cuenta, era crear imágenes que mezclaran varios dígitos juntos y luego alimentarlas en un modelo de IA con etiquetas híbridas, o "suaves". (Piensa en un caballo y un rinoceronte que tienen rasgos parciales de un unicornio.)

"Si piensas en el dígito 3, también se parece al dígito 8 pero nada al dígito 7", explica Ilia Sucholutsky, estudiante de doctorado en Waterloo y autor principal del artículo. "Las etiquetas blandas tratan de capturar estas características compartidas. Así que en vez de decirle a la máquina, 'Esta imagen es el dígito 3', decimos, 'Esta imagen es 60% el dígito 3, 30% el dígito 8, y 10% el dígito 0'.

Los límites del aprendizaje LO-shot learning

Una vez que los investigadores utilizaron con éxito las etiquetas blandas para lograr el aprendizaje de LO-shot en el MNIST, comenzaron a preguntarse hasta dónde podría llegar esta idea.

¿Existe un límite en el número de categorías que puedes enseñar a un modelo de IA a identificar a partir de un pequeño número de ejemplos?

Sorprendentemente, la respuesta parece ser no. Con etiquetas suaves cuidadosamente diseñadas, incluso dos ejemplos podrían teóricamente codificar cualquier número de categorías. "Con dos puntos, puedes separar mil clases o 10.000 clases o un millón de clases", afirma Sucholutsky.

Esto es lo que los investigadores demuestran en su último trabajo, a través de una exploración puramente matemática. Juegan el concepto con uno de los más simples algoritmos de aprendizaje por máquina, conocido como vecinos más cercanos (kNN), que clasifica los objetos usando un enfoque gráfico.

Para entender cómo funciona kNN, tomemos como ejemplo la tarea de clasificar frutas. Si quieres entrenar un modelo kNN para entender la diferencia entre manzanas y naranjas, primero debes seleccionar las características que quieres usar para representar cada fruta. Tal vez elijas el color y el peso, así que para cada manzana y naranja, alimentas el kNN con un punto de datos con el color de la fruta como su valor x yel peso como su valor y.

El algoritmo kNN traza entonces todos los puntos de datos en un gráfico 2D y dibuja una línea límite recta por el medio entre las manzanas y las naranjas.

En este punto, el gráfico se divide claramente en dos clases, y el algoritmo puede decidir ahora si los nuevos puntos de datos representan uno u otro según el lado de la línea en el que caen.

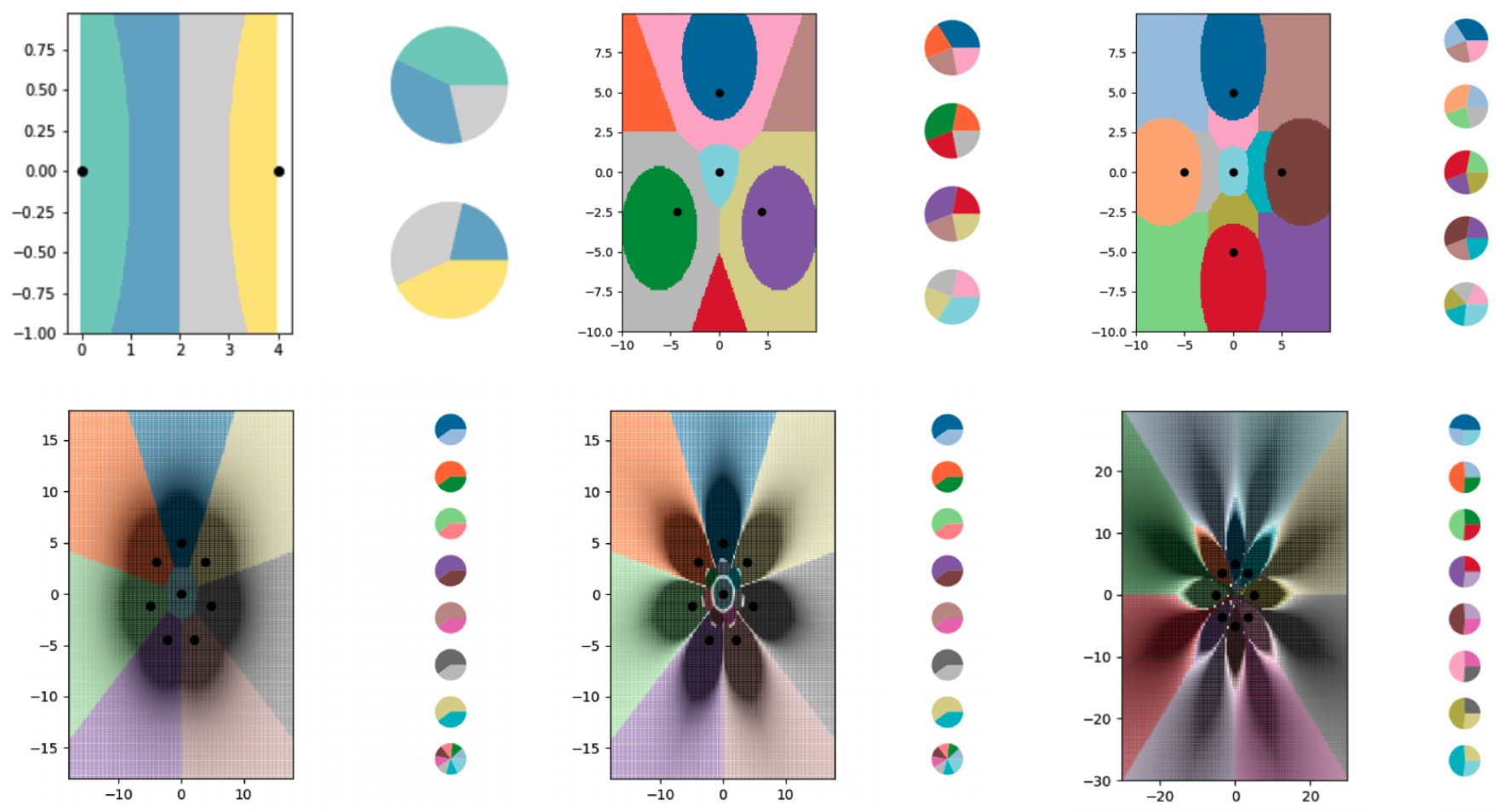

Para explorar el aprendizaje de los puntos de vista con el algoritmo kNN, los investigadores crearon una serie de pequeños conjuntos de datos sintéticos y diseñaron cuidadosamente sus etiquetas blandas.

Luego dejaron que el kNN trazara las líneas límite que estaba viendo y encontraron que dividió exitosamente el gráfico en más clases que puntos de datos. Los investigadores también tenían un alto grado de control sobre dónde caían las líneas límite. Usando varios ajustes a las etiquetas blandas, pudieron conseguir que el algoritmo de kNN dibujara patrones precisos en la forma de las flores.

Los investigadores utilizaron ejemplos de etiquetas blandas para entrenar un algoritmo kNN para codificar líneas límite cada vez más complejas, dividiendo el gráfico en muchas más clases que puntos de datos. Cada una de las áreas coloreadas de los gráficos representa una clase diferente, mientras que los gráficos circulares al lado de cada gráfico muestran la distribución de la etiqueta blanda para cada punto de datos.

ILIA SUCHOLUTSKY ET AL.

Por supuesto, estas exploraciones teóricas tienen algunos límites.

Mientras que la idea del aprendizaje de los LO-shot debería transferirse a algoritmos más complejos, la tarea de ingeniería de los ejemplos etiquetados como blandos se hace sustancialmente más difícil.

El algoritmo kNN es interpretable y visual, lo que hace posible que los humanos diseñen las etiquetas; las redes neuronales son complicadas e impenetrables, lo que significa que lo mismo puede no ser cierto.

La destilación de datos, que funciona para diseñar ejemplos de etiquetado suave para redes neuronales, también tiene una gran desventaja: requiere que se comience con un conjunto de datos gigantesco para reducirlo a algo más eficiente.

Sucholutsky dice que ahora está trabajando en la búsqueda de otras formas de diseñar estos minúsculos conjuntos de datos sintéticos, ya sea diseñándolos a mano o con otro algoritmo. A pesar de estos desafíos adicionales de investigación, sin embargo, el documento proporciona los fundamentos teóricos para el aprendizaje de LO-shot. "La conclusión es que dependiendo del tipo de conjuntos de datos que tengas, probablemente puedas obtener enormes ganancias de eficiencia", afirma Sucholutsky.

Esto es lo que más le interesa a Tongzhou Wang, un estudiante de doctorado del MIT que dirigió la investigación anterior sobre la destilación de datos. "El trabajo se basa en un objetivo realmente novedoso e importante: aprender modelos poderosos a partir de pequeños conjuntos de datos", comenta de la contribución de Sucholutsky.

Ryan Khurana, un investigador del Instituto de Ética de la IA de Montreal, igual afirma: "Lo más significativo es que el aprendizaje de 'menos de un tiro' reduciría radicalmente los requisitos de datos para construir un modelo funcional".

Esto podría hacer la IA más accesible a las empresas e industrias que hasta ahora se han visto obstaculizadas por los requisitos de datos del campo. También podría mejorar la privacidad de los datos, porque se tendría que extraer menos información de los individuos para formar modelos útiles.

Sucholutsky enfatiza que la investigación aún es temprana, pero está muy ilusionado. Cada vez que comienza a presentar su trabajo a sus colegas investigadores, asegura que la reacción inicial es la de decirle que la idea es imposible. Cuando de repente se dan cuenta de que no lo es, se abre un mundo completamente nuevo.

FUENTE: MIT TECHNOLOGY REVIEW